OrangePi AIPro:次世代嵌入式边缘AI计算与智能机器人应用开发平台

近年来,随着物联网(IoT)和人工智能(AI)技术的快速发展,嵌入式边缘计算板卡在智能设备中的应用越来越广泛。OrangePi AIpro作为一款轻量化高性能的嵌入式边缘人工智能计算SoC,在硬件配置、AI性能和使用便利性方面都有着突出的表现。本文将详细评测OrangePi AIpro的各个方面性能表

近年来,随着物联网(IoT)和人工智能(AI)技术的快速发展,嵌入式边缘计算板卡在智能设备中的应用越来越广泛。OrangePi AIpro作为一款轻量化高性能的嵌入式边缘人工智能计算SoC,在硬件配置、AI性能和使用便利性方面都有着突出的表现。本文将详细评测OrangePi AIpro的各个方面性能表现,通过部署测试主流AI架构和算法,并对比OrangePi AIpro、NVIDIA Jetson Xavier NX性能表现,为广大技术爱好者和开发者提供其AI性能等方面参考。

一、硬件配置

香橙派(Orange Pi)是深圳市迅龙软件有限公司旗下开源产品品牌,迅龙软件成立于2005年,是全球领先的开源硬件和开源软件服务商,致力于让极客、创客、电子爱好者享用到来自中国的优质、低价的科技产品,通过大规模的社会化协作去创建一个更加美好的信息化人类明。

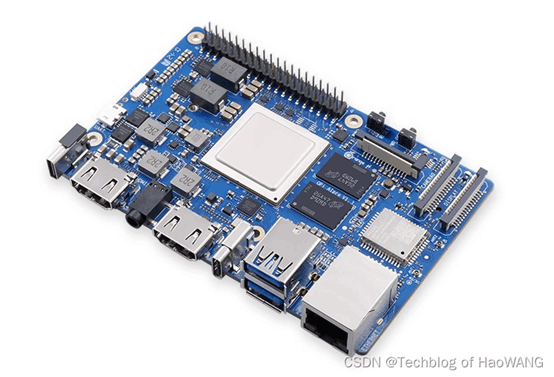

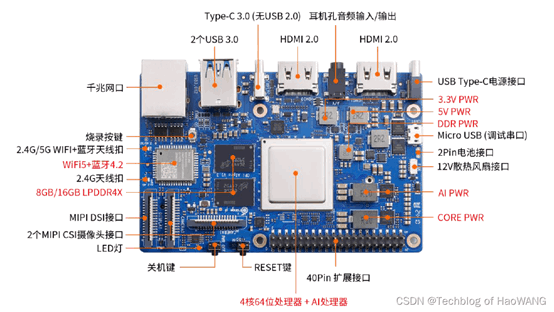

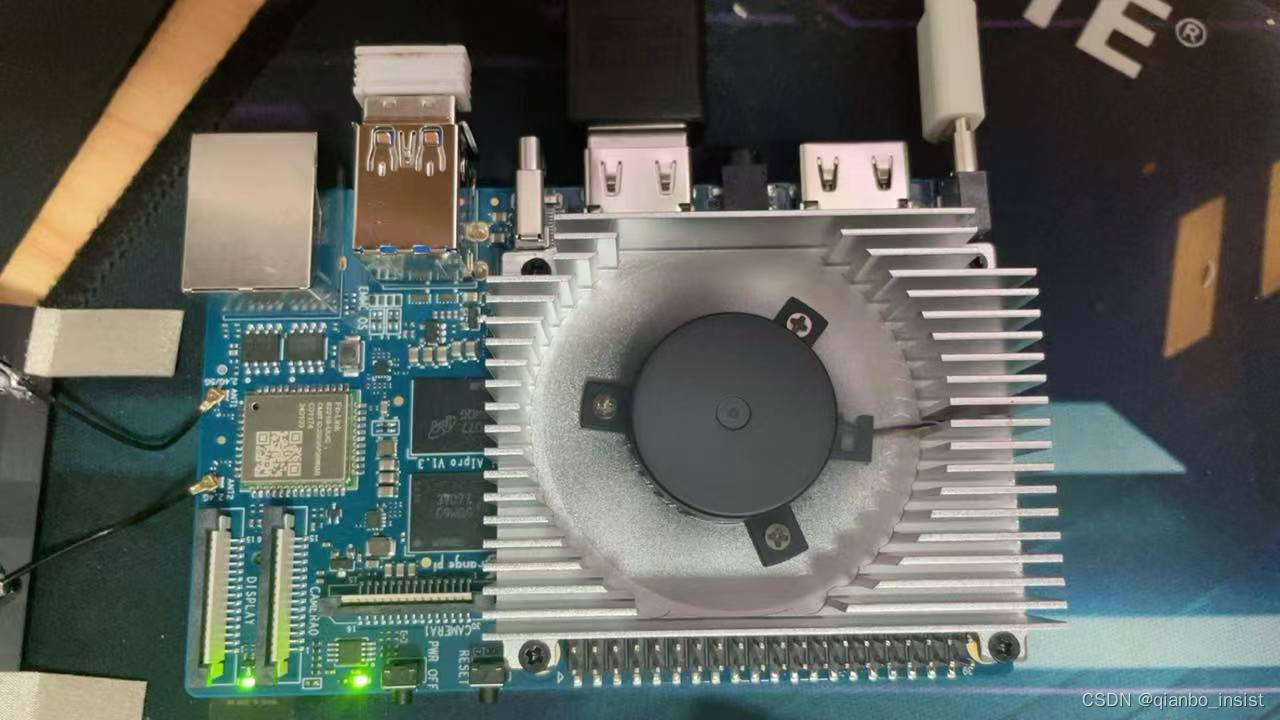

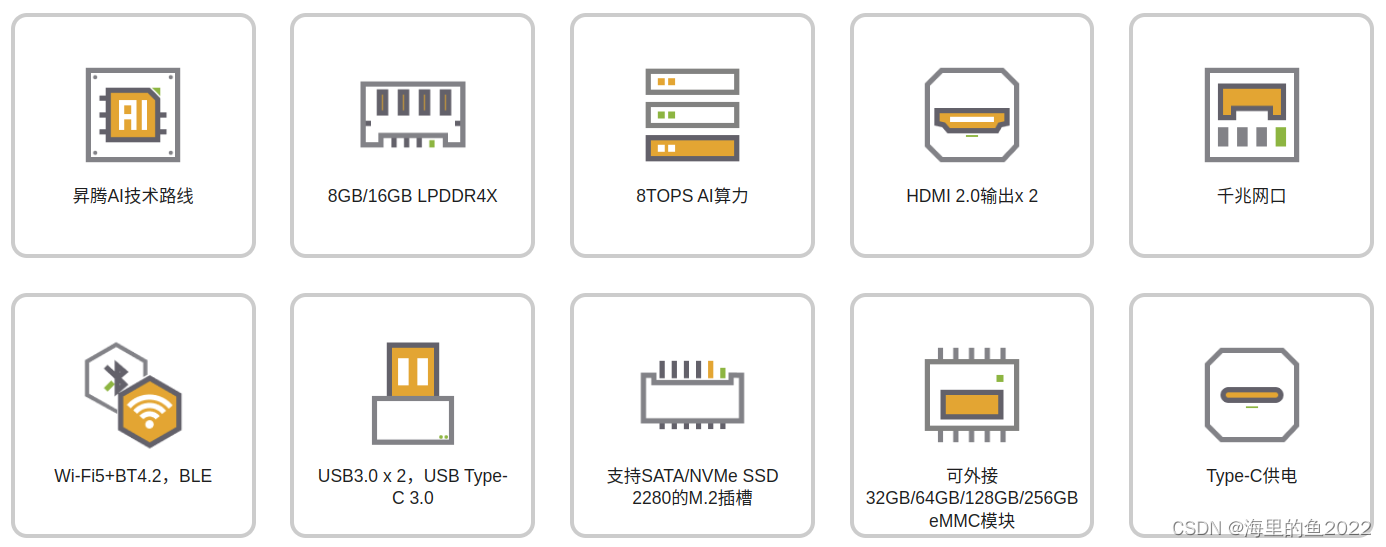

OrangePi AIpro(8T)采用昇腾AI技术路线,具体为4核64位处理器+AI处理器,集成图形处理器,支持8TOPS AI算力,拥有8GB/16GB LPDDR4X,可以外接32GB/64GB/128GB/256GB eMMC模块,支持双4K高清输出。

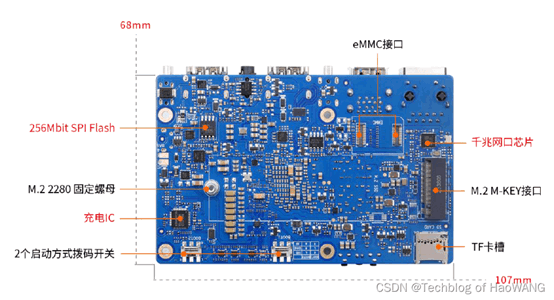

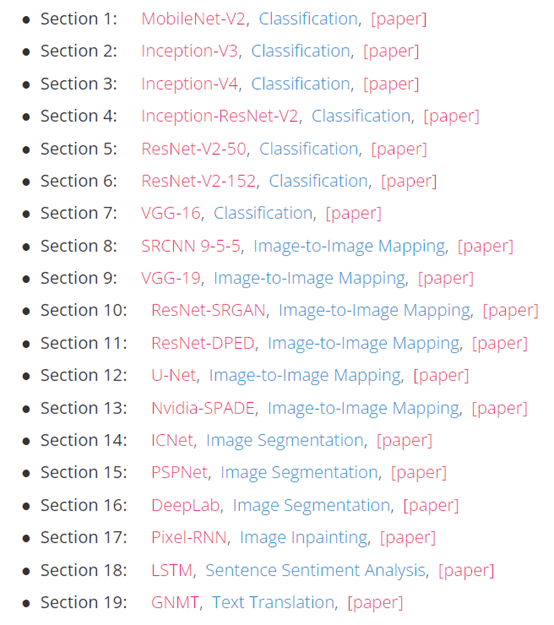

Fig.1. OrangePi AIpro 8T

Fig.2. OrangePi AIpro 8T Module

Orange Pi AIpro引用了相当丰富的接口,包括两个HDMI输出、GPIO接口、Type-C电源接口、支持SATA/NVMe SSD 2280的M.2插槽、TF插槽、千兆网口、两个USB3.0、一个USB Type-C 3.0、一个Micro USB(串口打印调试功能)、两个MIPI摄像头、一个MIPI屏等,预留电池接口,可广泛适用于AI边缘计算、深度视觉学习及视频流AI分析、视频图像分析、自然语言处理、智能小车、机械臂、人工智能、无人机、云计算、AR/VR、智能安防、智能家居等领域,覆盖 AIoT各个行业。 Orange Pi AIpro支持Ubuntu、openEuler操作系统,满足大多数AI算法原型验证、推理应用开发的需求。

1.1 处理器

OrangePi AIpro(8T) SoC 搭载了一颗64位四核ARM Cortex-A73 CPU 和NPU图形处理单元。该处理器不仅能提供强大的计算能力,还支持多种视频编解码格式,是多媒体处理和AI计算的理想选择。

Table1. 硬件规格参数清单

|

CPU |

4核64位处理器+ AI处理器 |

|

GPU |

集成图形处理器 |

|

AI算力 |

8TOPS算力 |

|

内存 |

LPDDR4X:8GB/16GB(可选),速率:3200Mbps |

|

存储 |

• SPI FLASH:32MB |

|

WIFI+蓝牙 |

Wi-Fi 5双频2.4G和5G |

|

以太网收发器 |

10/100/1000Mbps以太网 |

|

显示 |

• 2xHDMI2.0 Type-A TX 4K@60FPS |

|

摄像头 |

2x2-lane MIPI CSI camera interface,兼容树莓派摄像头 |

|

USB |

• USB 3.0 HOST x2 |

|

音频 |

3.5mm耳机孔音频输入/输出 |

|

按键 |

1x关机键、1xRESET键、2x启动方式拨动键、1x烧录按键 |

|

40PIN |

40PIN 功能扩展接口,支持以下接口类型: |

|

风扇 |

风扇接口x1 |

|

预留接口 |

2PIN电池接口 |

|

电源 |

Type-C PD 20V IN ,标准65W |

|

支持的操作系统 |

Ubuntu、openEuler |

|

产品尺寸 |

107*68mm |

|

重量 |

82g |

1.2 内存与存储

OrangePi AIPro配备了LPDDR4X:8GB/16GB(可选),速率:3200Mbps,确保了在运行复杂AI模型时的流畅性。此外,它还支持最大256GB的eMMC存储, SATA/NVME SSD(M.2接口2280), 用户可以根据需求选择不同容量的存储模块。同时,板载MicroSD卡插槽,方便用户进行扩展存储和快捷启动。

1.3 接口

为了满足各种外设连接需求,OrangePi AIPro提供了丰富的接口,包括两个HDMI输出、GPIO接口、Type-C电源接口、支持SATA/NVMe SSD 2280的M.2插槽、TF插槽、千兆网口、两个USB3.0、一个USB Type-C 3.0、一个Micro USB(串口打印调试功能)、两个MIPI摄像头、一个MIPI屏等,预留电池接口,可广泛适用于AI边缘计算、深度视觉学习及视频流AI分析、视频图像分析、自然语言处理、智能小车、机械臂、人工智能、无人机、云计算、AR/VR、智能安防、智能家居等领域,覆盖 AIoT各个行业。

|

显示 |

• 2xHDMI2.0 Type-A TX 4K@60FPS

|

|

摄像头 |

2x2-lane MIPI CSI camera interface,兼容树莓派摄像头 |

|

USB |

• USB 3.0 HOST x2 |

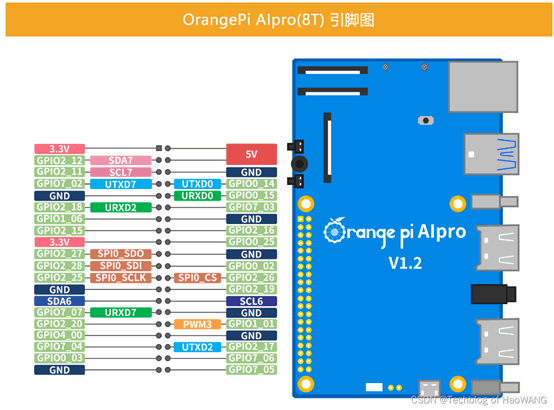

为方便嵌入式控制开发,OrangePi AIPro板载了40Pin接口插针,配有GPIO、UART、I2C、SPI、I2S和PWM输出, 采用 BCM编码规则,是更底层的工作方式,它和Broadcom的片上系统中信道编号相对应。在使用一个引脚时,你需要查找信道号和物理引脚编号之间的对应规则。

|

40PIN |

40PIN 功能扩展接口,支持以下接口类型: |

|

风扇 |

风扇接口x1 |

|

预留接口 |

2PIN电池接口 |

|

电源 |

Type-C PD 20V IN ,标准65W |

1.4 系统烧录

注:本方法为基于Windows PC 将Linux 镜像烧写到TF 卡的方法,更多方法请查考官方《用户手册》Orange Pi AIpro Orange Pi官网-香橙派(Orange Pi)开发板,开源硬件,开源软件,开源芯片,电脑键盘

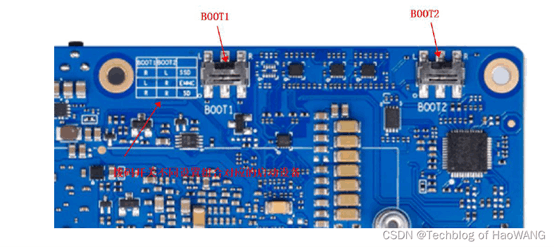

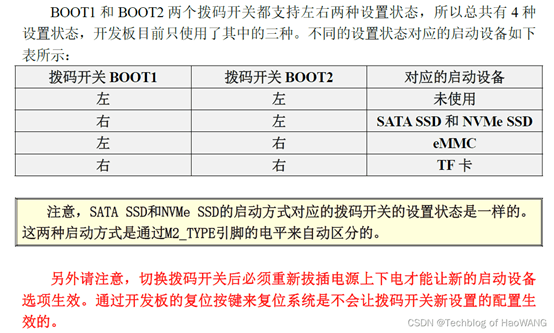

开发板支持从TF 卡、eMMC 和SSD(支持NVMe SSD 和SATA SSD)启动。具体从哪个设备启动是由开发板背面的两个拨码(BOOT1 和BOOT2)开关来控制。

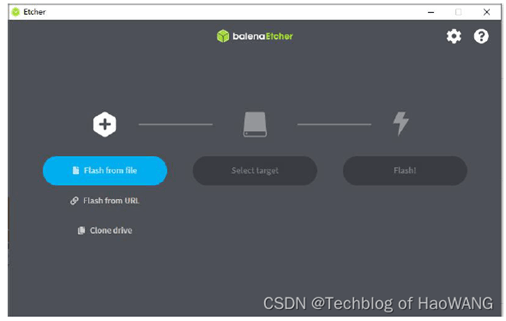

工具:balenaEtcher

系统:Ubuntu22.04 LTS

1.5 SSH工具

Filezilla apt-get安装

sudo apt-get install filezilla

Nomachine 安装

https://downloads.nomachine.com/download/?id=118&distro=ARM

下载并安装arm64对应版本的NoMachine:

sudo dpkg -i XXX

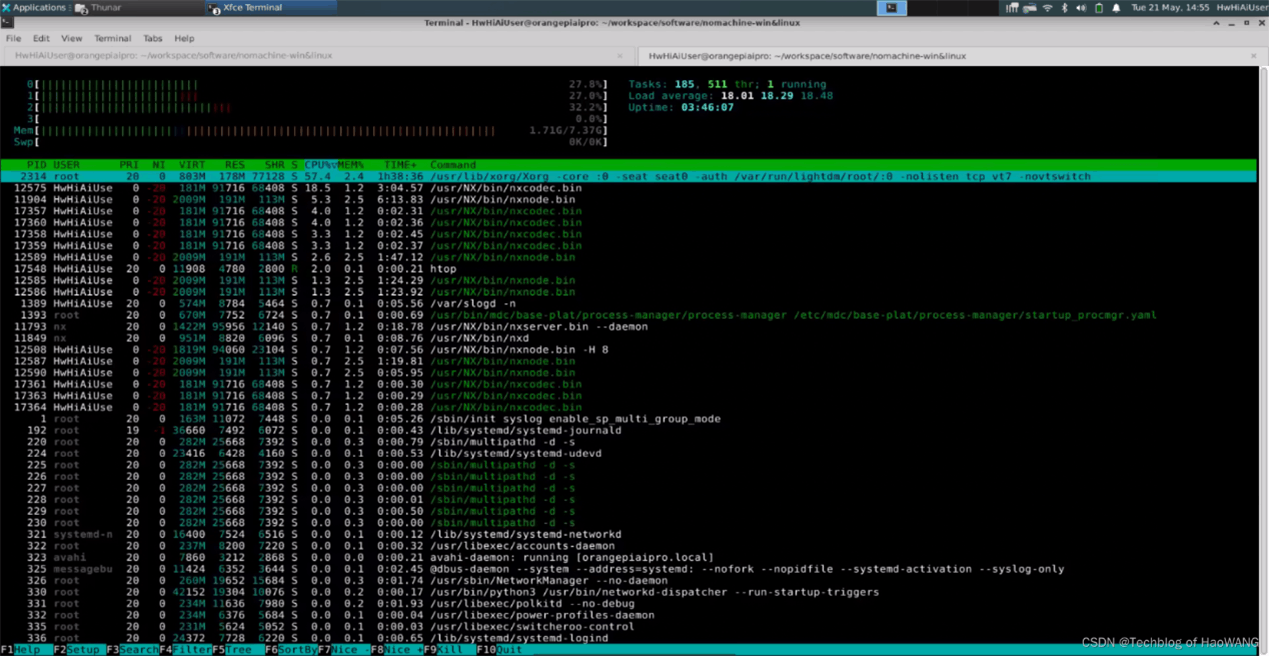

系统资源占用:

二、AI性能测试

AI性能是衡量嵌入式边缘计算板卡的重要指标之一。OrangePi AIPro在这方面表现优秀。

2.1 NPU(神经网络处理单元)

板载一颗专用的NPU,支持高达8TOPS(每秒万亿次操作)的算力。这使得OrangePi AIPro在处理复杂的神经网络模型时表现出色,适用于图像识别、语音识别、自然语言处理等应用场景。

为了使用NPU单元,需要做一些准备工作,torch_npu的Ascend Extension for PyTorch插件,使昇腾NPU可以适配PyTorch框架,为使用PyTorch框架的开发者提供昇腾AI处理器的超强算力。 pytorch: Ascend Extension for PyTorch

PyTorch是业界流行的深度学习框架,用于开发深度学习训练脚本,默认运行在CPU/GPU上。在昇腾AI处理器上运行PyTorch业务时,需要搭建异构计算架构CANN(Compute Architecture for Neural Networks)软件开发环境,并安装PyTorch 框架,从而实现训练脚本的迁移、开发和调试。

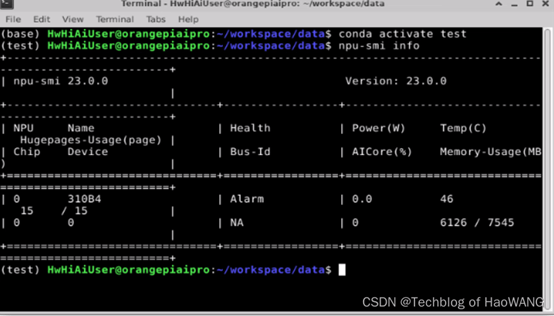

执行npu-smi info命令查看,出现类似如下信息,说明NPU驱动加载成功。

2.1.1 CANN

1. CANN依赖安装

在安装torch_npu之前,需要先安装CANN软件。昇腾辅助软件中有更多关于CANN的版本信息。请参考CANN安装指南获取CANN安装包。

CANN软件安装过程需要下载相关依赖,请确保安装环境能够连接网络,并已配置软件源,以下步骤以root用户操作为例。

Ubuntu系统安装第三方依赖(Debian、UOS20、Linux等系统操作一致):

sudo apt-get install -y gcc g++ make cmake zlib1g zlib1g-dev openssl libsqlite3-dev libssl-dev libffi-dev unzip pciutils net-tools libblas-dev gfortran libblas32. 安装Python及其依赖,以安装Python 3.7.5为例,其他版本可自行选择对应套件。

1)通过wget命令下载python3.7.5源码包。

wget https://www.python.org/ftp/python/3.7.5/Python-3.7.5.tgz

2)解压缩源码包

tar -zxvf Python-3.7.5.tgz

3)源码编译安装Python。

cd Python-3.7.5

./configure --prefix=/usr/local/python3.7.5 --enable-loadable-sqlite-extensions --enable-shared

make

make install

以--prefix=/usr/local/python3.7.5路径为例进行说明。执行配置、编译和安装命令后,安装包在/usr/local/python3.7.5路径。

4)设置python3.7.5环境变量。

#用于设置python3.7.5库文件路径

export LD_LIBRARY_PATH=/usr/local/python3.7.5/lib:$LD_LIBRARY_PATH

#如果用户环境存在多个python3版本,则指定使用python3.7.5版本

export PATH=/usr/local/python3.7.5/bin:$PATH

5)检查是否安装成功。

python3 --version

pip3 --version

返回相关版本信息,则说明安装成功。

6)安装pip依赖。

pip3 install attrs numpy decorator sympy cffi pyyaml pathlib2 psutil protobuf scipy requests absl-py

3. 安装CANN开发者套件

1. 从昇腾社区“CANN”产品页,根据操作系统架构下载CANN开发套件包。

例如:“Ascend-cann-toolkit_6.3.RC1_linux-x86_64.run”

2. 安装CANN开发套件包。

# 添加可执行权限

sudo chmod +x Ascend-cann-toolkit_6.3.RC1_linux-x86_64.run

# 校验软件包的一致性和完整性

./Ascend-cann-toolkit_6.3.RC1_linux-x86_64.run --check

# 执行安装命令

./Ascend-cann-toolkit_6.3.RC1_linux-x86_64.run --install --install-for-all

3. 安装完成后,若显示如下信息,则说明软件安装成功:

[INFO] xxx install success

2.1.2 Pytorch和torch_npu

pytorch: Ascend Extension for PyTorch

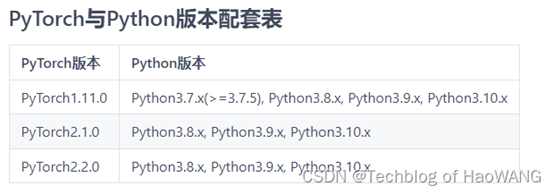

CANN软件包安装完成后,就可以进行PyTorch的安装了,这里选择PyTorch 1.8.1,PyTorch安装成功后再安装APEX混合精度模块。在安装Pytorch前,需要先安装以下依赖。

pip3 install wheel

pip3 install typing_extensions

安装PyTorch 1.8.1

1)安装官方torch包。

aarch64架构

wget https://repo.huaweicloud.com/kunpeng/archive/Ascend/PyTorch/torch-1.8.1-cp37-cp37m-linux_aarch64.whl

pip3 install torch-1.8.1-cp37-cp37m-linux_aarch64.whl

2)安装PyTorch适配插件torch_npu。

aarch64架构

wget https://gitee.com/ascend/pytorch/releases/download/v5.0.rc1-pytorch1.8.1/torch_npu-1.8.1.post1-cp37-cp37m-linux_aarch64.whl

pip3 install torch_npu-1.8.1.post1-cp37-cp37m-linux_aarch64.whl

此处以5.0.rc1版本为例,实际请选择CANN配套的PyTorch插件版本进行安装。

3)安装对应框架版本的torchvision。

pip3 install torchvision==0.9.1

4)验证是否安装成功。

python -c "import torch;import torch_npu; a = torch.ones(3, 4).npu(); print(a + a);"

如果输出包含如下关键信息则说明PyTorch安装成功。

[[2., 2., 2., 2.],

[2., 2., 2., 2.],

[2., 2., 2., 2.]]

2.2 AI开发工具

板卡配套了丰富的AI开发工具,包括模型转换工具、优化工具等,帮助开发者将AI模型高效地移植到NPU上运行。官方还提供了详细的开发文档和示例代码,降低了上手难度。

OrangePi拥有活跃的用户社区,开发者可以在社区中交流经验、分享代码、解决问题。官方还提供了技术支持,用户在使用过程中遇到任何问题都可以寻求帮助。欢迎您欢迎您欢迎您

CANN(Compute Architecture for Neural Networks)是华为针对AI场景推出的异构计算架构,对上支持多种AI框架,对下服务AI处理器与编程,发挥承上启下的关键作用,是提升昇腾AI处理器计算效率的关键平台。同时针对多样化应用场景,提供高效易用的编程接口,支持用户快速构建基于昇腾平台的AI应用和业务。

可部署的开源项目包括:

samples: CANN Sampleshttps://gitee.com/ascend/samples

ModelLink旨在为华为 昇腾芯片 上的大语言模型提供端到端的解决方案, 包含模型,算法,以及下游任务。

ModelLink: 昇腾大模型仓库https://gitee.com/ascend/ModelLink

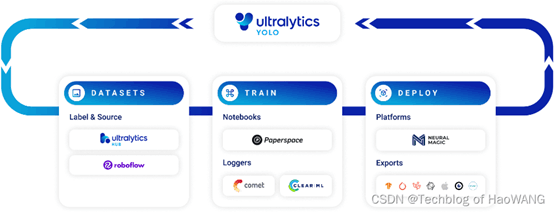

2.3 AI部署YOLOV8

OrangePi AIPro兼容多种主流的AI框架,如TensorFlow、PyTorch和Caffe等。这意味着开发者可以方便地将已有的AI模型部署到板卡上,进行边缘计算任务。

测试案例1:YOLOV8- Ultralytics YOLOv8

Install the ultralytics package using pip, or update an existing installation by running:

pip install -U ultralytics

pip install onnxruntime

Visit the Python Package Index (PyPI) for more details on the ultralytics package: ultralytics · PyPI.

安装成功

Successfully installed contourpy-1.1.1 cycler-0.12.1 filelock-3.14.0 fonttools-4.51.0 fsspec-2024.5.0 importlib-resources-6.4.0 jinja2-3.1.4 kiwisolver-1.4.5 matplotlib-3.7.5 mpmath-1.3.0 networkx-3.1 opencv-python-4.9.0.80 pandas-2.0.3 pyparsing-3.1.2 python-dateutil-2.9.0.post0 pytz-2024.1 pyyaml-6.0.1 scipy-1.10.1 seaborn-0.13.2 sympy-1.12 thop-0.1.1.post2209072238 torch-2.3.0 torchvision-0.18.0 tqdm-4.66.4 typing-extensions-4.11.0 tzdata-2024.1 ultralytics-8.2.18

Successfully installed coloredlogs-15.0.1 humanfriendly-10.0 onnxruntime-1.18.0

安装代码包:

You can also install the ultralytics package directly from the GitHub repository. This might be useful if you want the latest development version. Make sure to have the Git command-line tool installed on your system. The @main command installs the main branch and may be modified to another branch, i.e. @my-branch, or removed entirely to default to main branch.

# Install the ultralytics package from GitHub

pip install git+https://github.com/ultralytics/ultralytics.git@main

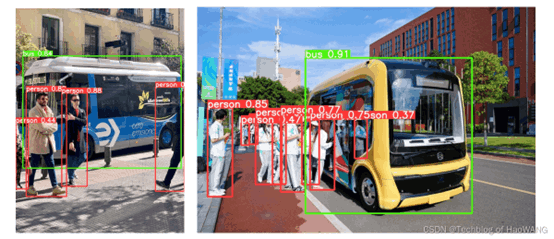

2.4 YOLO V8测试demo

2.4.1. Image Detection

demo1 - Detection - yolo8n.onnx model

输入图像:

输出结果:

代码:

#!/usr/bin/python3

from ultralytics import YOLO

# Load a model

model = YOLO("../model/yolov8n.onnx") # pretrained YOLOv8n model

# Run batched inference on a list of images

filename1 = ["../image/bus.jpg", "../image/human.png"]

results = model(filename1, stream=True) # return a generator of Results objects

# Process results generator

idx = 0

for result in results:

idx = idx +1

boxes = result.boxes # Boxes object for bounding box outputs

masks = result.masks # Masks object for segmentation masks outputs

keypoints = result.keypoints # Keypoints object for pose outputs

probs = result.probs # Probs object for classification outputs

obb = result.obb # Oriented boxes object for OBB outputs

result.show() # display to screen

result.save(filename="../image/result"+str(idx)+".jpg") # save to disk

2.4.2 Video Tracking

demo2 - Tracking -yolo8n.onnx model

检测结果视频流1-Human:

检测结果视频流2-Car:

代码:

#!/usr/bin/python3

import cv2

from ultralytics import YOLO

# Load the YOLOv8 model

model = YOLO("../model/yolov8n.onnx")

# Open the video file

video_path = "../video/car.mp4"

cap = cv2.VideoCapture(video_path)

# Loop through the video frames

while cap.isOpened():

# Read a frame from the video

success, frame = cap.read()

if success:

# Run YOLOv8 tracking on the frame, persisting tracks between frames

results = model.track(frame, persist=True)

# Visualize the results on the frame

annotated_frame = results[0].plot()

# Display the annotated frame

cv2.imshow("YOLOv8 Tracking", annotated_frame)

# Break the loop if 'q' is pressed

if cv2.waitKey(1) & 0xFF == ord("q"):

break

else:

# Break the loop if the end of the video is reached

break

# Release the video capture object and close the display window

cap.release()

cv2.destroyAllWindows()

三、Benchmark测试

对于开发者来说,硬件的易用性和软件的支持是选择开发板的重要考虑因素。OrangePi AIPro在这方面也做得相当出色。测试对象:NVIDIA Jetson Xavier NX(√)、OrangePi AIpro(√)、树莓派4B(X)

3.1 测试环境及软件

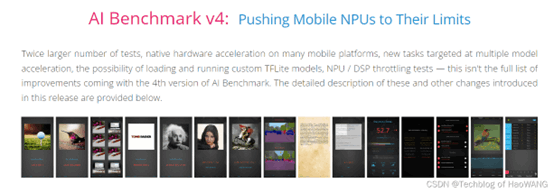

3.1.1 AI Benchmark V4

OrangePiAIrpo 支持多种开发环境,如Python、C++等,开发者可以使用熟悉的编程语言进行开发。此外,OrangePi AIPro还兼容Arduino生态系统,用户可以利用Arduino IDE进行开发,极大地提高了开发效率。

本次测试使用的AI-Benchmark 是一个用于评估人工智能算法的硬件性能的基准测试套件。它包含了多个测试模块,涵盖了计算机视觉、自然语言处理等多个领域。通过运行AI Benchmark,用户可以测试不同硬件平台上的性能表现,并比较不同算法的效率和准确性。AI Benchmark旨在为人工智能研究者和开发者提供一个标准化的测试环境,帮助他们更好地评估和优化自己的算法和系统。

While Machine Learning is already a mature field, for many years it was lacking a professional, accurate and lightweight tool for measuring AI performance of various hardware used for training and inference with ML algorithms. Today we are making a step forward towards standardizing the benchmarking of AI-related silicon, and present a new standard for all-round performance evaluation of hardware platforms capable of running machine and deep learning models.

3.1.2 配置 AI Benchmark

适用于 Linux 、Windows和 macOS 的 AI 基准测试

1. 创建测试环境

conda create -n test python=3.8

2. 安装python库,该基准测试依赖于 TensorFlow 机器学习库,为评估关键深度学习模型的推理和训练速度提供精确且轻量级的解决方案。

pip install tensorflow

注报错hdf5依赖问题时做如下操作:

sudo apt install pkg-config libhdf5-dev

Successfully installed MarkupSafe-2.1.5 absl-py-2.1.0 astunparse-1.6.3 cachetools-5.3.3 certifi-2024.2.2 charset-normalizer-3.3.2 flatbuffers-24.3.25 gast-0.4.0 google-auth-2.29.0 google-auth-oauthlib-1.0.0 google-pasta-0.2.0 grpcio-1.64.0 h5py-3.11.0 idna-3.7 importlib-metadata-7.1.0 keras-2.13.1 libclang-18.1.1 markdown-3.6 numpy-1.24.3 oauthlib-3.2.2 opt-einsum-3.3.0 packaging-24.0 protobuf-4.25.3 pyasn1-0.6.0 pyasn1-modules-0.4.0 requests-2.32.1 requests-oauthlib-2.0.0 rsa-4.9 six-1.16.0 tensorboard-2.13.0 tensorboard-data-server-0.7.2 tensorflow-2.13.1 tensorflow-cpu-aws-2.13.1 tensorflow-estimator-2.13.0 tensorflow-io-gcs-filesystem-0.35.0 termcolor-2.4.0 typing-extensions-4.5.0 urllib3-2.2.1 werkzeug-3.0.3 wrapt-1.16.0 zipp-3.18.2

3. AI Benchmark 目前以Python pip 包的形式分发,可以下载到运行 Windows、Linux 或 macOS 的任何系统。

pip install ai-benchmark

Successfully installed ai-benchmark-0.1.2 pillow-10.3.0 psutil-5.9.8 py-cpuinfo-9.0.0

3.2 测试用例

AI Benchmark包括 42 项测试和 19 个网络模型。这些测试涵盖了所有主要的深度学习任务和架构,因此对于研究人员、开发人员、硬件供应商和在其设备上运行人工智能应用程序的最终用户非常有用。

评分有关的指标有:

- CPU计算能力,CPU-Q(量化),CPU-F(浮点)

- INT8计算能力,包括NNAPI1.1和1.3,以及准确度

- FP16计算能力,包括NNAPI1.1和1.3,以及准确度

- 并行能力,包括INT8和FP16

- NLP能力,包括INT8和FP16

- 内存使用情况,包括INT8和FP16

● INT8, NNAPI-1.1 Compatible Tests

● INT8, NNAPI-1.2 Compatible Tests

● INT8, Parallel Model Execution

● INT8, Single / Multi-Thread CPU Tests

● INT8, Accuracy Tests

● INT8, Initialization Time

● FP16, NNAPI-1.1 Compatible Tests

● FP16, NNAPI-1.2 Compatible Tests

● FP16, Parallel Model Execution

● FP16, Single / Multi-Thread CPU Tests

● FP16, Accuracy Tests

● FP16, Initialization Time

● FP16, RNN / LSTM Tests

● FP32, RNN / LSTM Tests

● FP16, Memory Tests

3.3 测试结果

>> AI-Benchmark-v.0.1.2

>> Let the AI Games begin..* TF Version: 2.13.1

* Platform: Linux-5.10.0+-aarch64-with-glibc2.26

* CPU: N/A

* CPU RAM: 7 GBThe benchmark is running...

The tests might take up to 20 minutes

Please don't interrupt the script1/19. MobileNet-V2

1.1 - inference | batch=50, size=224x224: 2680 ± 51 ms

2/19. Inception-V3

2.1 - inference | batch=20, size=346x346: 7665 ± 19 ms

3/19. Inception-V4

3.1 - inference | batch=10, size=346x346: 7839 ± 61 ms

4/19. Inception-ResNet-V2

4.1 - inference | batch=10, size=346x346: 8738 ± 82 ms

5/19. ResNet-V2-50

5.1 - inference | batch=10, size=346x346: 4704 ± 42 ms

6/19. ResNet-V2-152

6.1 - inference | batch=10, size=256x256: 7244 ± 13 ms

7/19. VGG-16

7.1 - inference | batch=20, size=224x224: 13639 ± 178 ms

8/19. SRCNN 9-5-5

8.1 - inference | batch=10, size=512x512: 12158 ± 64 ms

8.2 - inference | batch=1, size=1536x1536: 11131 ± 125 ms9/19. VGG-19 Super-Res

9.1 - inference | batch=10, size=256x256: 20765 ± 38 ms

9.2 - inference | batch=1, size=1024x1024: 33328 ± 92 ms10/19. ResNet-SRGAN

10.1 - inference | batch=10, size=512x512: 16565 ± 44 ms

10.2 - inference | batch=1, size=1536x1536: 14941 ± 64 ms11/19. ResNet-DPED

11.1 - inference | batch=10, size=256x256: 18605 ± 37 ms

11.2 - inference | batch=1, size=1024x1024: 29720 ± 38 ms12/19. U-Net

12.1 - inference | batch=4, size=512x512: 40274 ± 52 ms

12.2 - inference | batch=1, size=1024x1024: 40498 ± 60 ms13/19. Nvidia-SPADE

13.1 - inference | batch=5, size=128x128: 16530 ± 39 ms

14/19. ICNet

14.1 - inference | batch=5, size=1024x1536: 7750 ± 65 ms

15/19. PSPNet

15.1 - inference | batch=5, size=720x720: 86634.0 ± 0.0 ms

16/19. DeepLab

16.1 - inference | batch=2, size=512x512: 19256 ± 30 ms

17/19. Pixel-RNN

17.1 - inference | batch=50, size=64x64: 7507 ± 35 ms

18/19. LSTM-Sentiment

18.1 - inference | batch=100, size=1024x300: 36360 ± 6 ms

19/19. GNMT-Translation

19.1 - inference | batch=1, size=1x20: 7493 ± 4 ms

Device Inference Score: 97

代码:

#!/usr/bin/python3

from ai_benchmark import AIBenchmark

import warnings

import numpy as np

np.warnings = warnings

benchmark = AIBenchmark()

results = benchmark.run_inference()

3.4 对比分析

Orange Pi AIpro VS NVIDIA Jetson Xavier NX

在嵌入式AI计算领域,Nvidia的Jetson Xavier NX和Orange Pi的AIpro是两款颇受欢迎的计算平台。下面将基于硬件性能、AI性能和实际应用体验来对比评价这两款产品:

硬件性能

Jetson Xavier NX搭载了512核心的Nvidia Volta GPU和六核心的Carmel ARMv8.2 CPU,同时配备了8GB的LPDDR4x内存,堪称业界顶尖。它具备丰富的硬件接口,如PCIe Gen4、USB 3.1等,方便进行扩展。但是,其高昂的售价无形中提高了AI算力终端部署门槛。

相比之下,Orange Pi AIpro更为适合小型项目开发和部署使用,它搭载的是四核心的Cortex-A55 CPU,并配备了8GB的DDR4内存。同时,它提供的GPIO接口则相对更丰富,便于进行各种硬件开发和扩展。

AI性能

在AI性能方面,Jetson Xavier NX因采用了Nvidia专门设计的Tensor Cores张量核心,其理论最高算力能达到21 TOPS,这让它在复杂的AI任务(如自然语言理解、计算机视觉等)中表现出色。

相比之下,Orange Pi AIpro的AI性能也不逊色,它的NPU支持高达8 TOPS的算力,并且兼容多种主流的AI框架,借助华为CANN异构计算框架,可以适配如TensorFlow、PyTorch和Caffe等,非常适用于边缘计算任务。

实际应用体验

在我实际使用的过程中,Jetson Xavier NX无疑提供了更强大的性能,我能够在上面轻松运行复杂的深度学习模型。但是,它的开发环境较为复杂,需要一些时间来熟悉。

相比之下,Orange Pi AIpro虽然在性能上稍逊,但却更胜一筹的是其出色的易用性。适合大多数中,低至入门级别的AI应用场景,系统安装简洁流畅,并且支持多种程序设计语言,如Python和C++。

对比来看,对于需要高性能AI计算和复杂AI模型处理的应用,Jetson Xavier NX会是比较好的选择。而对于边缘计算应用和中小规模的AI项目,Orange Pi AIpro因其出色的易用性和相对低廉的价格,可能会是更理想的选择。

四、总结

OrangePi AIPro搭载华为A310B4 NPU处理器,其作为一款64位四核ARM Cortex-A55架构的处理器,为复杂运算及多媒体处理提供了坚实的算力基础。此外,设备内置了8GB DDR4内存和最大256GB eMMC存储,确保在数据密集型任务下的运行流畅性及存储需求的灵活扩展。尤其值得关注的是,设备内嵌NPU,算力突出,理论峰值可达到8TOPS,这在图像识别、语音处理等深度学习任务中表现尤佳。

适用场景

首先,在智能家居领域,其低延迟、高能效的特性使其在实时处理和环境感知任务中表现尤佳。其次,在物联网网关的应用中,设备的丰富接口(包括USB 3.0、HDMI、千兆以太网等)极大地提高了网络连接和数据处理的灵活性。最后,在工业自动化中,其强大的NPU对于复杂的机器视觉及智能控制任务提供了坚实的支持。

试用体验

在实际使用过程中,我首先选择了基于Linux操作系统环境的开发,官方提供的详细文档有效地降低了上手难度。加载操作系统后,我尝试了多个深度学习模型的部署与测试。得益于其高效的NPU,设备在处理实时图像识别任务时表现出色,尤其在多人实时监控和面部识别的应用场景中,数据处理速度明显加快。

在开发过程中,我使用Python及C++两种语言进行模型的开发与部署;硬件丰富的接口设计(如GPIO)为外设连接及数据传输提供了极大的便利性。基于TensorFlow框架,我部署了一些基于卷积神经网络(CNN)的计算机视觉检测相关模型,运行过程中设备的稳定性和计算性能给人留下深刻印象。

OrangePi AIPro作为一款高性能嵌入式NPU计算板卡,具有突出的硬件配置和卓越的计算性能,尤其适用于智能家居、物联网及工业自动化等场景。其易用性和丰富的开发资源大大降低了开发门槛,是从事边缘人工智能研究及应用开发的理想选择。 未来,随着嵌入式AI计算需求的不断增长,OrangePi AIPro无疑将成为开发者手中的利器。

总结

OrangePi AIPro作为一款高性能的嵌入式边缘人工智能计算板卡,在硬件配置、AI性能和使用便利性方面都表现出了很高的水平。它不仅能满足复杂的边缘计算需求,还为开发者提供了丰富的开发工具和资源。无论是用于人工智能技术、嵌入式计算、智能家居、自动化应用还是智慧城市,OrangePi AIPro都是一个值得推荐的选择。通过这篇评测,希望能帮助广大技术爱好者和开发者更好地了解和使用OrangePi AIPro,加速AI项目的开发进程。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)